کامپیوترهای کوانتومی و هوشمصنوعی

رایانش کوانتومی(Quantum computing)

رایانش کوانتومی به بخشی از تحقیقات علمی در زمینه کامپیوتر ها گفته می شود. که بر روی توسعه کامپیوتر هایی بر مبنای نظریه کوانتوم که طبیعت و رفتار انرژی و ماده را در سطح کوانتومی (اتمی و زیراتمی) مورد بررسی قرار می دهد متمرکز شده است.ترکیب کامپیوترهای کوانتومی و هوشمصنوعی امروزه یکی از هیجان انگیزترین چالش های دانشمندان و برنامه نویسان می باشد.

اختراع کامپیوتر های کوانتومی نشان دهنده ی جهشی عظیم در توانایی پردازش کامپیوتر ها، چه نسبت به ساده ترین آن ها (Abacus) گرفته و چه نسبت به ابرکامپیوتر های مدرن خواهد بود . در واقع، میزان بهبود عملکرد کامپیوترهای کوانتومی نسبت به کامپیوتر های فعلی در محدوده میلیون ها برابر بهتر می باشد. کامپیوتر کوانتومی با پیروی از قوانین فیزیک کوانتومی توان پردازش عظیمی را به دست خواهد آورد. این بهبود عملکرد از طریق توانایی داشتن چندین حالت مختلف و انجام دستورات مختلف با استفاده از تمام جایگشت های ممکن در یک زمان واحد به دست می آید. مراکز فعلی تحقیق در زمینه کامپیوتر های کوانتومی شامل MIT،IBM، دانشگاه آکسفورد و آزمایشگاه ملی Los Alamos می باشند.

مبانی اصلی کامپیوتر های کوانتومی در سال 1981 توسط Paul Benioff که در آزمایشگاه های ملی Argonne کار می کرد ایجاد شد. او به طور نظری یک کامپیوتر کلاسیک را طراحی کرد که با برخی از اصول مکانیک کوانتومی کار می کرد.

اما بنیان و پایه اصلی کامپیوترهای کوانتومی در سال 1982 میلادی توسط ریچارد فیلیپس فاینمن – فیزیکدان بزرگ و برنده جایزه نوبل – مطرح شد. او پیشنهاد کرد که میتوان محاسبات را از دنیای دیجیتال، به دنیای جدید کوانتوم وارد کرد. پیشنهادی که البته تا اوایل دهه 90 میلادی مورد توجه جدی قرار نگرفت، اما در سال 1994 پیتر شور که در یکی از دانشگاه های آمریکا مشغول به تحقیق بود، نخستین قدم برای ورود به این جهان جدید را برداشت.

برخی از جامعه علمی بر این باور اند که David Deutsch از دانشگاه آکسفورد انگیزه اصلی برای تحقیق در زمینه کامپیوتر های کوانتومی را ایجاد کرد. در سال 1984 به فکر طراحی کامپیوتر هایی افتاد که به صورت انحصاری از قوانین کوانتوم پیروی کنند. سپس چند ماه بعد او مقاله خود را به عنوان اولین مقاله در این زمینه منتشر کرد. با انتشار این مقاله رقابتی داغ برای بهره برداری از ایده های او به وجود آمد. اما قبل از این که به بررسی موضوعی که او آغازگرش بود بپردازیم بهتر است تا نگاهی به پس زمینه دنیای کوانتوم داشته باشیم.

کامپیوترهای کوانتومی

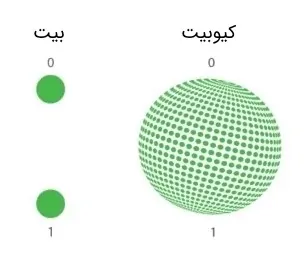

ویژگیهای اصلی کامپیوترهای معمولی مثل بیت، الگوریتم، گیتهای منطقی و … به طور مشابه در کامپیوترهای کوانتومی هم وجود دارند. اصلیترین جزء یک کامپیوتر کوانتومی، در واقع واحد پردازش اطلاعات، بیت کوانتومی یا کیوبیت است. عملکرد یک کیوبیت شاید کمی مبهم به نظر بیاید.

همانطور که میدانید یک بیت کلاسیک در هر لحظه تنها میتواند یکی از دو مقدار ۰ و ۱ را داشته باشد. اما یک کیوبیت در هر لحظه هم میتواند ۰ باشد و هم ۱ یا حتی هر چیزی دیگری بین ۰ و ۱ !. در واقع یک کیوبیت در حالت «برهمنهی» از حالتهای پایه ۰ و ۱ است. برای مشخص شدن حالت کیوبیت باید آن را اندازهگیری کرد. در این صورت حالت برهمنهی فرو ریخته و کیوبیت با یک احتمالی در 0 و یا ۱ ظاهر میشود.

کامپیوتر کوانتومی چگونه کار میکند؟

کامپیوتر کوانتومی ماشینی است که از پدیدهها و قوانین مکانیک کوانتوم برای انجام محاسباتش استفاده میکند که با رایانههای فعلی تفاوت اساسی داشته و سرعت حیرتانگیزی دارند. همچنین میتوانند از خواص و قوانین فیزیک کوانتوم برای ذخیرهسازی و انجام عملیات روی دادهها استفاده کنند.

مصداق فیزیکی یک بیت کلاسیکی میتواند دو سطح مختلف ولتاژ (مثلاً 0 و 5 ولت) یا روشن و خاموش شدن یک پالس لیزری باشد. هر سیستم دو حالته فیزیکی (ریزمقیاس) مانند اسپین بالا و پایین یک الکترون یا قطبش عمودی و افقی یک فوتون یا تغییر حالت یک اتم یا یون در سیستمی خاص میتواند برای تعریف کیوبیت به کار رود.

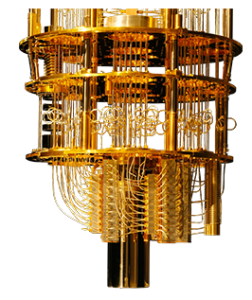

از آنجاییکه که سیستمهای ریزمقیاس و کوانتومی به شدت نویزپذیر بوده و حالتشان تغییر میکند، برای تعریف کیوبیتها و یا پردازش و کنترل آنها به مکانیزمهایی خاص و پیچیده نیاز داریم تا بتوانیم اتم، یون و … را در حالتی خاص قرار داده و یا به حالتهای دیگر ببریم.

قرار دادن کیوبیت (اتم، یون، فوتون و …) در یک حالت خاص، مصداق ذخیره اطلاعات و تغییر حالت آنها مصداق عمل پردازش بر روی کیوبیتها است. برای حذف نویز و ایزوله کردن سیستمهای کوانتومی از محیط بیرون معمولاً به تجهیزات گرانقیمتی جهت مهیا ساختن خلأ بسیار بالا و یا سرد کردن تا نزدیکی صفر مطلق نیاز است.

تا کنون روشهای متفاوتی جهت کنترل کیوبیتها، پیادهسازی گیتهای کوانتومی و الگوریتمهای کوانتومی ارائه شدهاند که هر یک مزایا و معایب خاص خود را دارا هستند. یکی از این روشها تعریف کیوبیت توسط نقاط کوانتومی است. نقاط کوانتومی که ذراتی نانومقیاس از نیمهرسانا بوده که شامل الکترون و حفره است.

یکی دیگر از روشهایی که نسبت به سایر روشها پیچیدگی کمتری دارد، تعریف کیوبیت و پیادهسازی گیتهای کوانتومی با استفاده از سیستمهای اپتیک خطی و غیرخطی است. از آنجایی که فوتونها نسبت به محیط بیرون و دیگر فوتونها ایزوله هستند، گزینهای مناسب و ارزان قیمت جهت تعریف کیوبیتها هستند. چرا که برای کار با آنها نیازی به دماهای خیلی سرد یا خلأ بالا نیست. البته این سیستم نیز مشکلات خاص خود را دارد. به طور مثال برای پیادهسازی گیتهای چند کیوبیتی (۲ ورودی به بالا) نیاز به برهمکنش فوتونها بوده که این برهمکنش تحت شرایطی خاص و به صورت احتمالی صورت میگیرد.

ترکیب کامپیوترهای کوانتومی و هوشمصنوعی

ترکیب کامپیوترهای کوانتومی و هوشمصنوعی میتواند بسیاری از پیشرفتهای مورد انتظار در دنیای فناوری را فعال کند.به گفته کارشناسان قدرت رایانههای سنتی در حد پردازش دادهها بوده و جالب اینکه تولید دادهها روز به روز در حال رشد است.

این موارد بهسادگی دلالت میکنند که ما برای پردازش دادهها در مقیاس گسترده، نیازمند محاسبات زیادی هستیم. چاره این کار، استفاده از پیشرفتهترین فناوریها یعنی کامپیوترهای کوانتومی و هوش مصنوعی است.

یک تحقیق توسط Research and Markets نشان میدهد که محاسبات کوانتومی و هوش مصنوعی با یکدیگر بسیار هم افزا هستند، زیرا محاسبات کوانتومی در حل مسئله به هوش مصنوعی سرعت میبخشد، و هوش مصنوعی یک ساختار یادگیری خودکار را برای محاسبات کوانتومی فراهم میکند. انتظار میرود که این ترکیب مزایای بسیاری از جمله کشف سریعتر پارامتر، تنظیم و حتی تنظیمات احتمالی الگوریتم را تسریع بخشد. این فراتر از واقعیت نیست که هوش مصنوعی ممکن است در مقطعی بر محدودیتهای سختافزاری محاسبات کوانتومی غلبه کند، و این امکان را به سیستمعاملها بدهد تا به ماشینهایی با ابعاد کمتر تبدیل شوند.

محققان ایتالیایی نشان دادهاند که امکان انتقال یک بیت کوانتومی یا (qubit) در آنچه که میتواند یک وضعیت دنیای واقعی نامیده شود، وجود دارد. آنها این کار را توسط هوش مصنوعی انجام دادند. پدیده انتقال qubit چیز جدیدی نیست، اما این کار که به سرپرستی Enrico Prati از انستیتوی فوتونیک و نانوتکنولوژی در میلان انجام شده، اولین باری است که در شرایطی انجام میشود که سیستم از شرایط ایدئال منحرف شده باشد.

این اولین بار است که یک کلاس از الگوریتمهای یادگیری ماشین موسوم به یادگیری تقویت عمیق برای یک مسئله محاسبات کوانتومی اعمال شده است.به نظر می رسد در آینده شاهد پیشرفت هایی عظیم در زمینه ی کامپیوترهای کوانتومی و هوشمصنوعی باشیم.

برنامه نویسی کوانتومی

شاید حتی جذاب تر از قدرت کامپیوتر های کوانتومی و هوشمصنوعی این نکته باشد که آن ها به ما اجازه می دهند تا برنامه ها را به روشی کاملا جدید بنویسیم. برای مثال یک کامپیوتر کوانتومی می تواند از یک توالی برنامه نویسی که مفهومش : ” تمام بر هم نهی های محاسبات قبلی را را ذخیره کن” است؛ استفاده کند. این دستور برای کامپیوتر های کلاسیک کاملا بی معنی است. البته همین دستور می تواند در حل بسیار سریع مسائل خاص ریاضی مانند پیدا کردن فاکتور های اعداد بزرگ به ما کمک کند. در ادامه به بررسی این مثال می پردازیم.

تاکنون 2 موفقیت قابل توجه در در زمینه برنامه نویسی کوانتومی اتفاق افتاده است :

اولین آن ها در سال 1994 توسط Peter Shor (که در حال حاضر در آزمایشگاه های AT&T کار می کند) انجام شد. او یک الگوریتم کوانتومی طراحی کرد که می توانست به صورت موثر فاکتور های اعداد بزرگ را پیدا کند. مبنای اصلی این الگوریتم سیستمی است که از نظریه اعداد برای تخمین دوره تناوب یک دنباله عددی بزرگ استفاده می کند.

موفقیت چشمگیر دوم توسط Lov Grover در آزمایشگاه Bell و در سال 1996 به دست آمد. او یک الگوریتم بسیار سریع طراحی کرد که ثابت شده سریع ترین الگوریتم ساخته شده برای جستجو در بانک های اطلاعاتی سازمان نیافته به شمار می رود. این الگوریتم آنقدر پر بازده است که به طور متوسط تنها به ریشه دوم N) N تعداد عناصر موجود است) جستجو نیاز دارد تا نتیجه مورد نظر را پیدا کند. در حالی که همین مسئله در کامپیوتر های کلاسیک به N/2 جستجو نیاز دارد.

کامپیوترها صرفنظر از سرعت، تمایل دارند بهصورت خطی فکر کنند،ولی انسانها اینگونه نیستند این فقط درباره تفاوتهای بدنی بین پردازندهها و مغز انسان نیست؛ این واقعیت است که مغز بهطور موازی مقدار زیادی از اطلاعات را پردازش میکند، و کامپیوترهای کلاسیک نمیتوانند این سطح عظیم موازی را تحمل کنند. اما با پیشرفت فناوری کامپیوترهای کوانتومی و هوشمصنوعی میتوانیم محاسبات بسیار عظیم را به صورت موازی انجام دهیم .